第5节 集群搭建

❤️💕💕新时代拥抱云原生,云原生具有环境统一、按需付费、即开即用、稳定性强特点。Myblog:http://nsddd.top

[TOC]

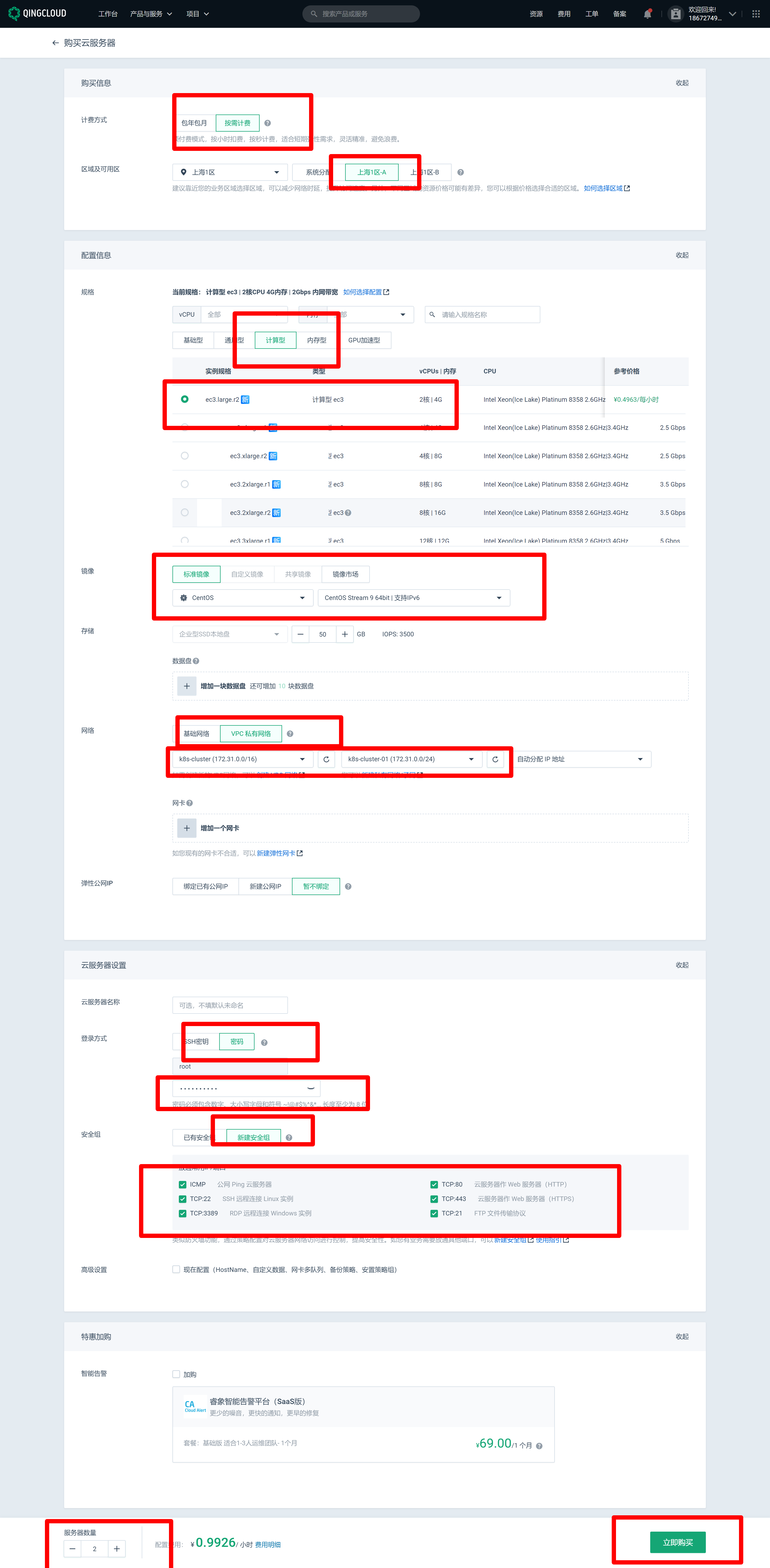

购买三台机器

在青鸟云上创建账户,并且联系客户申请IP扩容为三个

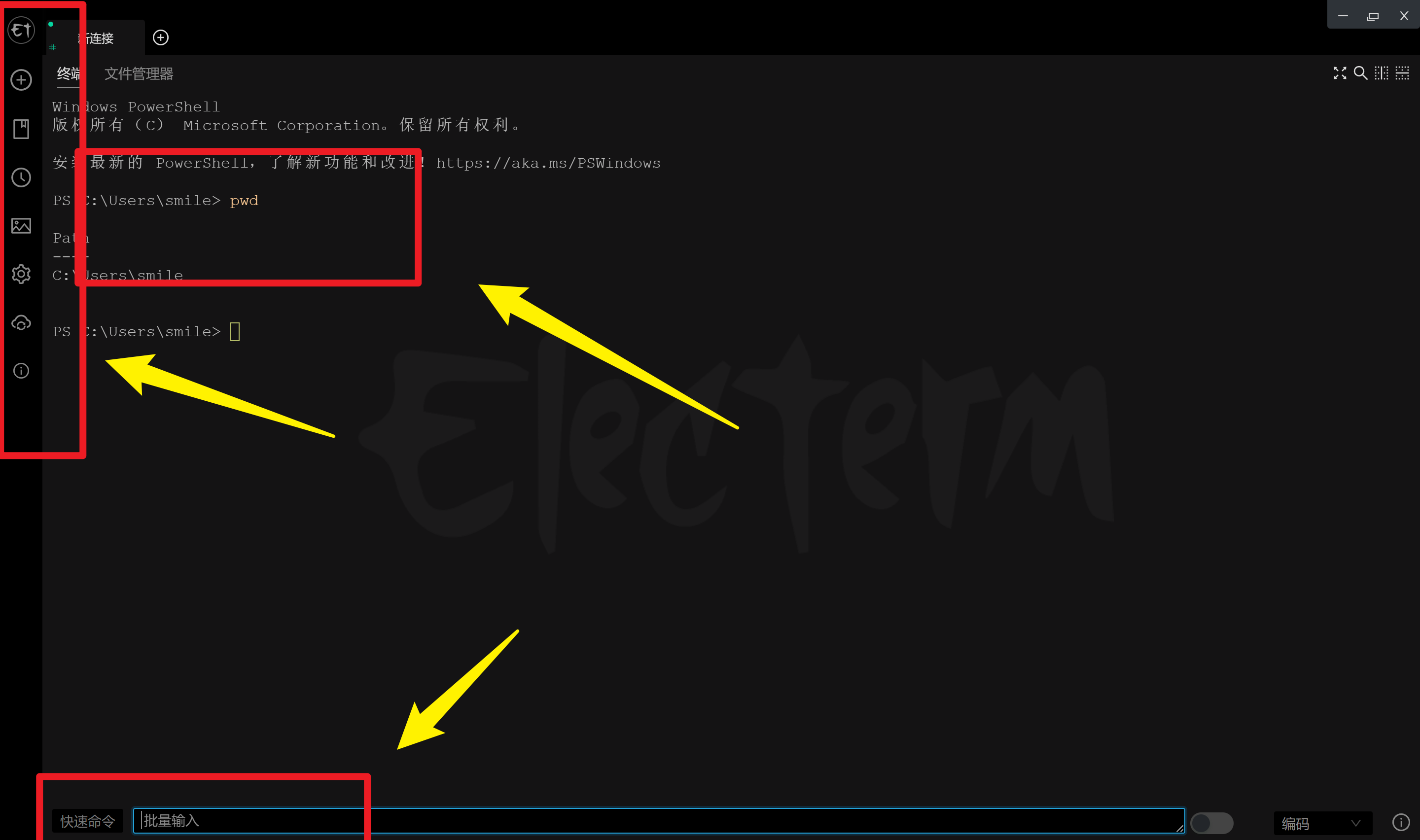

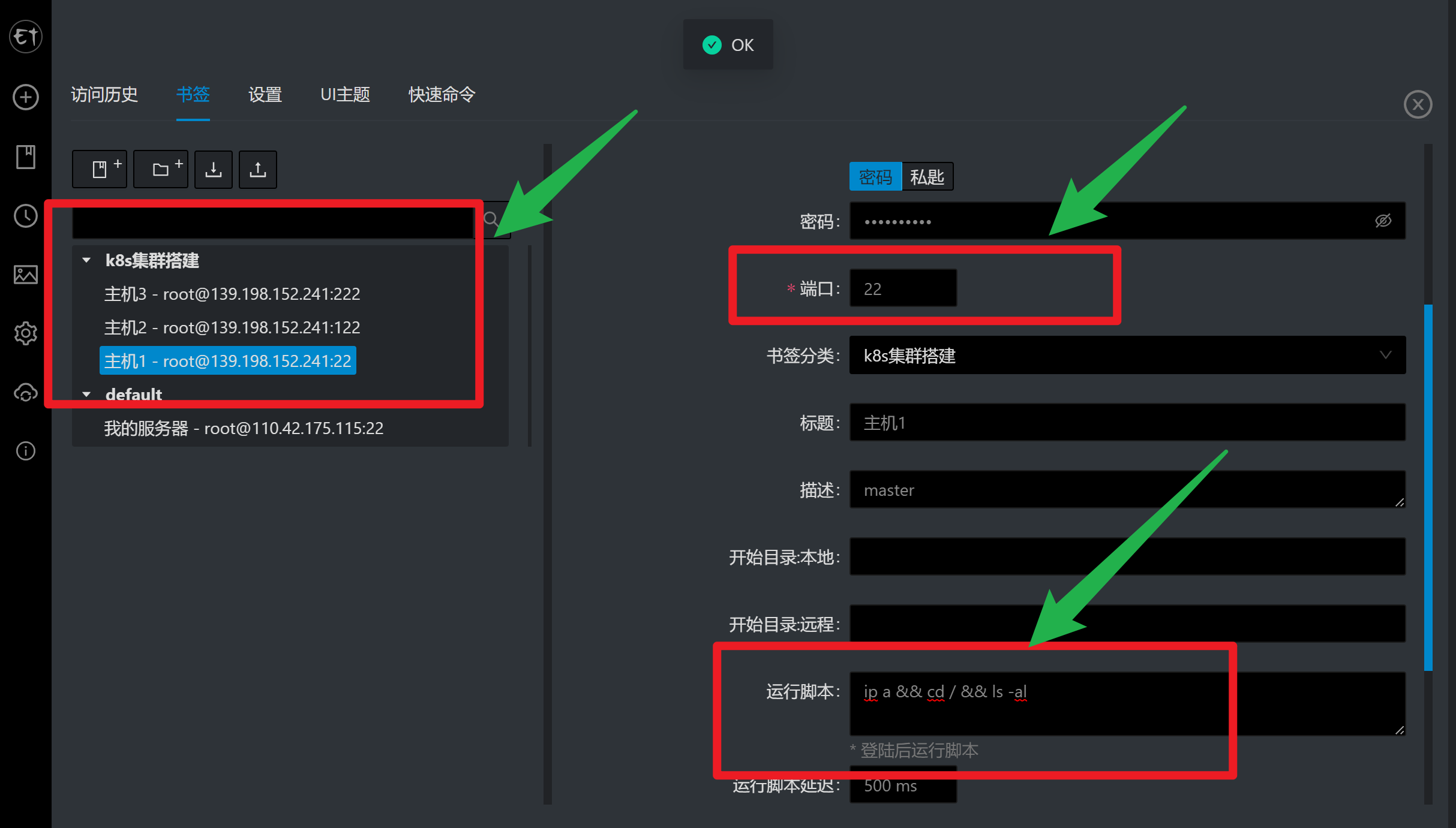

推荐使用一个远程ssh工具

支持批量的输入,很适合集群的搭建~

- [x] electerm开源地址

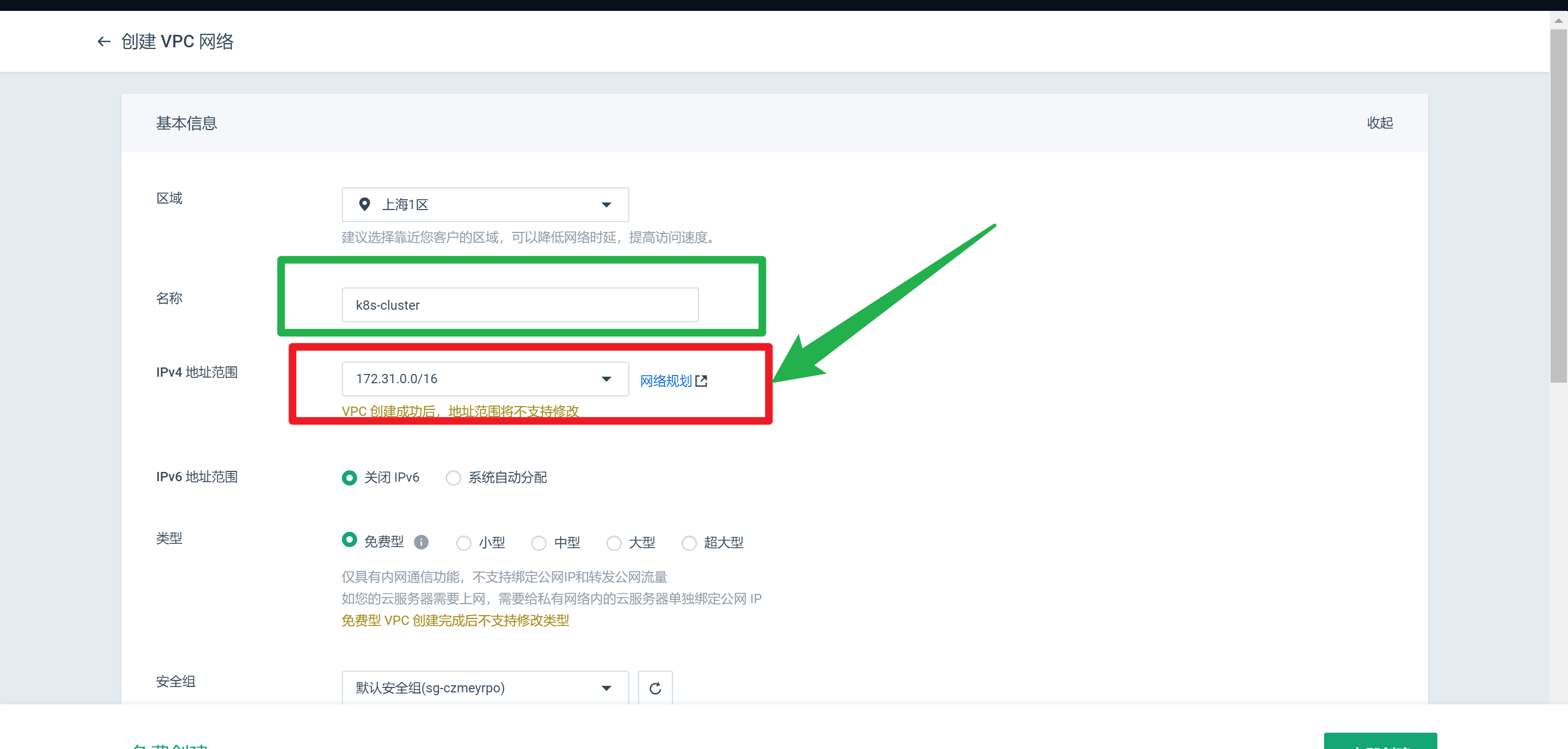

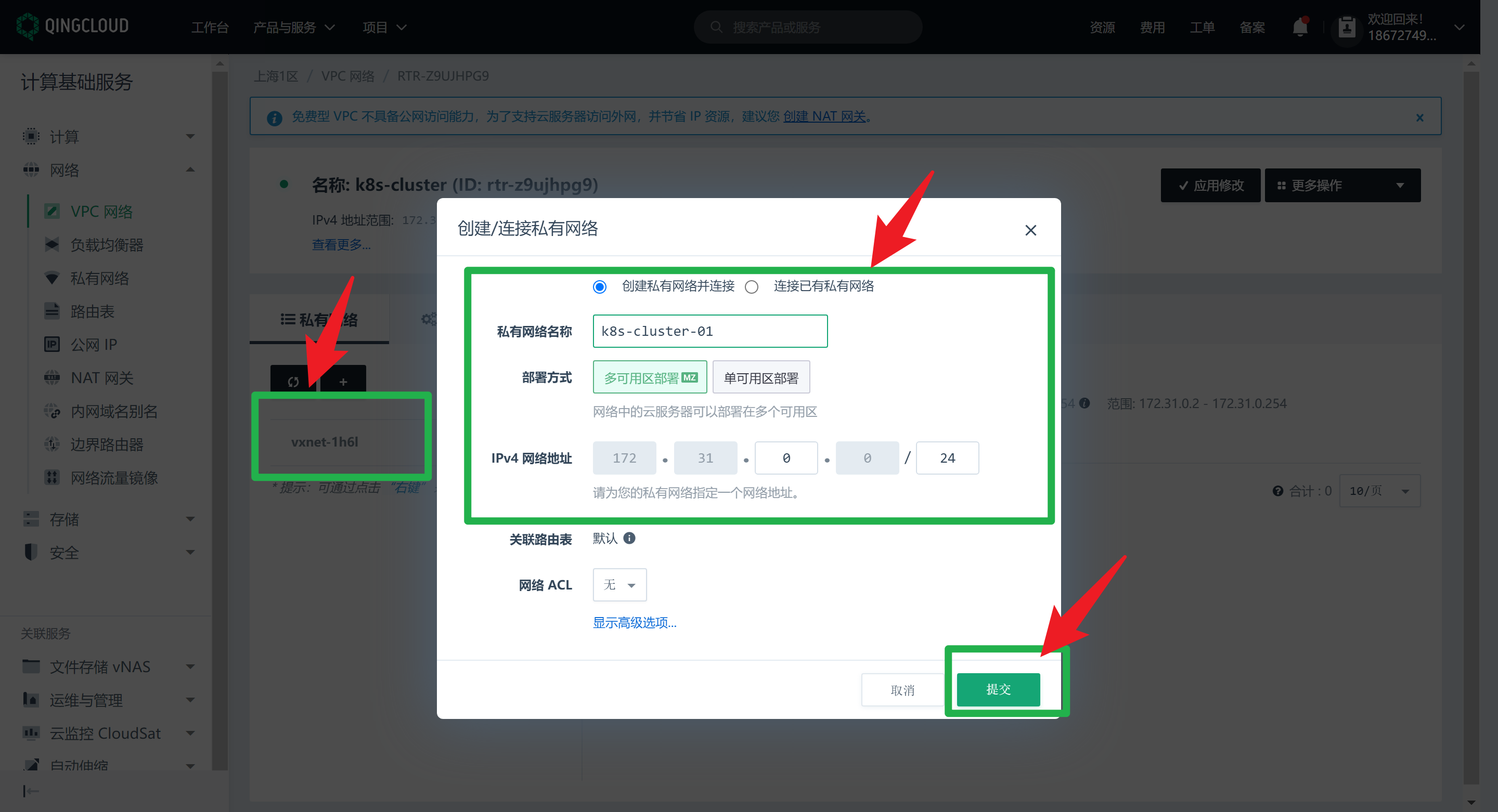

创建私有网络

使用交换机划分为隔离网络的小区域

过程截图

⚠️ 上面一定要注意:内网的范围一定要选择

172.31.0.24/24因为后面安装docker的时候,docker占了

172.17占了

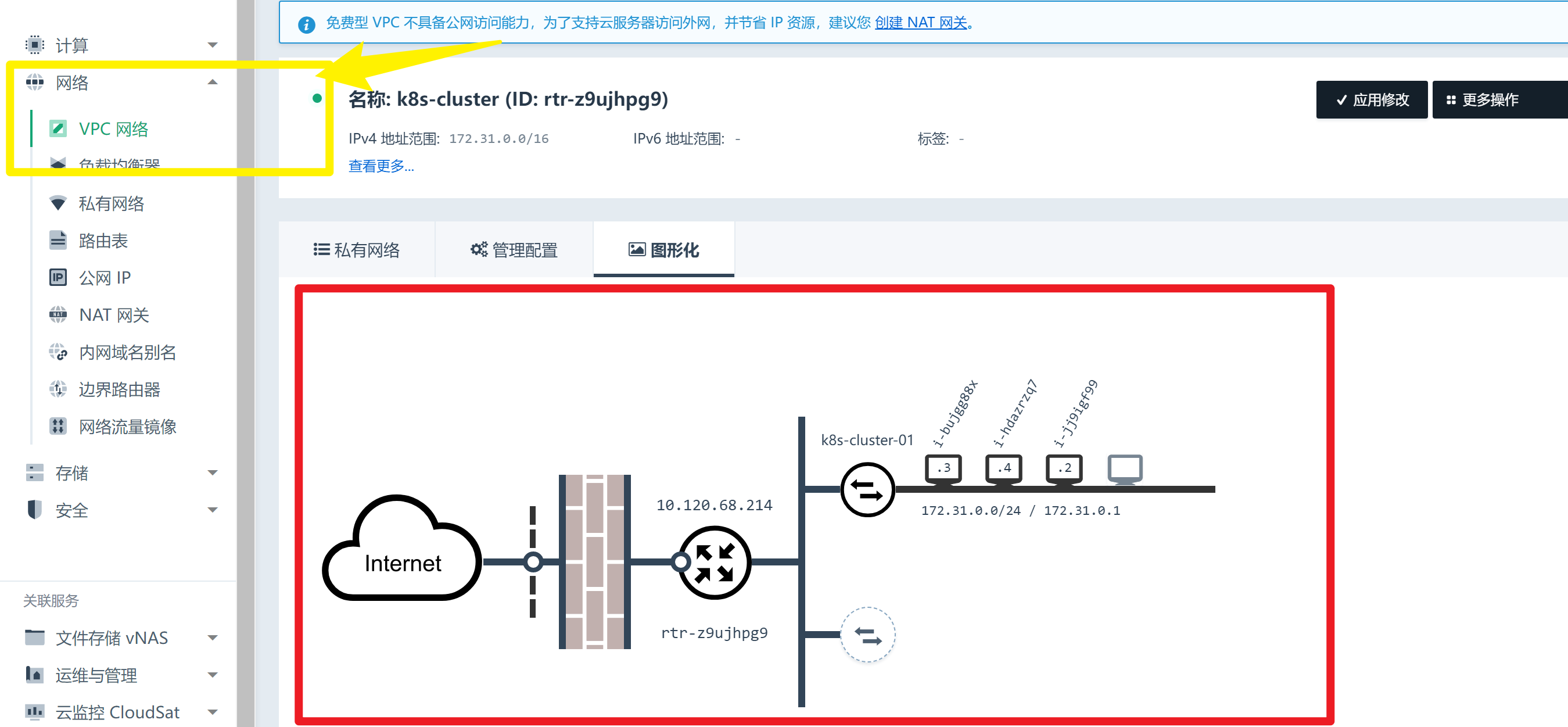

搭建成功

显示图形化界面

可以看到

vpc和防火墙以及三台主机之间的关联。

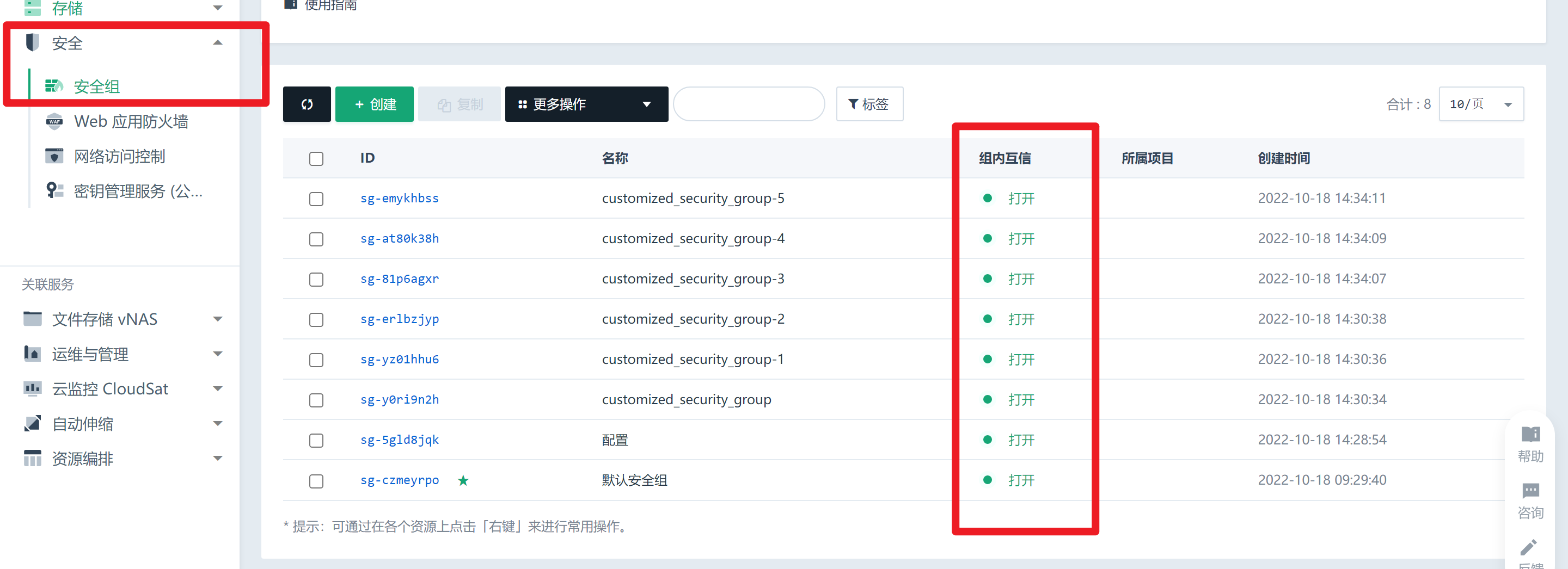

必须要打开安全组的组内通信

只有打开组内通信,防火墙即使不开端口也是可以互相访问的~

vpc设置端口转化

vpc默认免费的是不会提供公网IP的,因为现在公网的IP紧缺,所以vpc在一定程度上需要满足这个条件,使用vpc的端口转化,可以帮助我们解决问题。这是因为vpc外网端口可以自定义。

⚠️ 注意要开放对应的安全组

| 类型 | ID | 名称 | 角色 | 状态 | IP 地址 | IPv6 地址 | DHCP 选项 | 操作 |

|---|---|---|---|---|---|---|---|---|

| 云服务器 | i-jj9igf99 | 运行中 | 192.168.0.2 | [ 修改 ] | ||||

| 云服务器 | i-hdazrzq7 | 运行中 | 192.168.0.3 | [ 修改 ] | ||||

| 云服务器 | i-bujgg88x | 运行中 | 192.168.0.4 | [ 修改 ] |

准备链接

我开始也设置了一些基础的脚本,方便ce'shi

docker安装

1、移除以前docker相关包

sudo yum remove docker \

docker-client \

docker-client-latest \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-engine

2、配置yum源

sudo yum install -y yum-utils

sudo yum-config-manager \

--add-repo \

http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

3、安装docker

sudo yum install -y docker-ce docker-ce-cli containerd.io

#以下是在安装k8s的时候使用

yum install -y docker-ce-20.10.7 docker-ce-cli-20.10.7 containerd.io-1.4.6

4、启动

systemctl enable docker --now

5、配置加速

这里额外添加了docker的生产环境核心配置cgroup

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://82m9ar63.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2"

}

EOF

sudo systemctl daemon-reload

sudo systemctl restart docker

kubeadm创建集群预备环境

虽然有了 Kubernetes 的一些 预开发版本,比如说 k3s、 k0s、 minikuber、Kind、但是官方还是最推荐的 Kubeadm,而且在 kubernetes 1.3版本后也是可以将 kubeadm 用于生产环境。

安装kubeadm

一台兼容的 Linux 主机。Kubernetes 项目为基于 Debian 和 Red Hat 的 Linux 发行版以及一些不提供包管理器的发行版提供通用的指令

每台机器 2 GB 或更多的 RAM (如果少于这个数字将会影响你应用的运行内存)

2 CPU 核或更多(我测试的 2核2G 的很卡)

集群中的所有机器的网络彼此均能相互连接(公网和内网都可以)

设置防火墙放行规则

节点之中不可以有重复的主机名、MAC 地址或 product_uuid。请参见这里了解更多详细信息。

主机名:

[root@i-0xkmp3n1 /]#一般不会重复 设置不同hostname开启机器上的某些端口。请参见这里 了解更多详细信息。-- 内网互信

禁用交换分区。为了保证 kubelet 正常工作,你 必须 禁用交换分区。 永久关闭

设置所有机器的主机名称

hostnamectl set-hostname k8s-master # 第一台机器

hostnamectl set-hostname k8s-node2 # 第二台机器

hostnamectl set-hostname k8s-node3 # 第三台机器

将 SELinux 设置为 permissive 模式

将 SELinux 设置为 permissive 模式(相当于将其禁用)

sudo setenforce 0 #临时

sudo sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

关闭所有机器的交换分区

查看分区:

free -m

#关闭swap

swapoff -a #临时

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久

允许 iptables 检查桥接流量

cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf

br_netfilter

EOF

cat <<EOF | sudo tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sudo sysctl --system # 让配置生效

安装集群的三大件

我们上一节看到了马车的三大件,我们集群也是有三大件的😂😂

集群的搭建也是很有意思的,和redis的三主三从,Hadoop的搭建类似

安装kubelet、kubeadm、kubectl

cat <<EOF | sudo tee /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

exclude=kubelet kubeadm kubectl

EOF

sudo yum install -y kubelet-1.20.9 kubeadm-1.20.9 kubectl-1.20.9 --disableexcludes=kubernetes # 安装三大件

sudo systemctl enable --now kubelet # 所有机器启动kublet

需要注意的是:kubelet 现在每隔几秒就会重启,因为它陷入了一个等待 kubeadm 指令的死循环

使用kubeadm引导集群

- 下载各个机器需要的镜像

- 初始化主结点

- 根据提示继续

- 加入node结点

其实在

k8s中,除了kubelet(因为 kubelet 不能被阉割,它是容器和宿主机的桥梁),剩下的镜像都是以容器的方式运行。kubelet类似于厂长,我们为了避免下载中断,所以准备的是脚本。

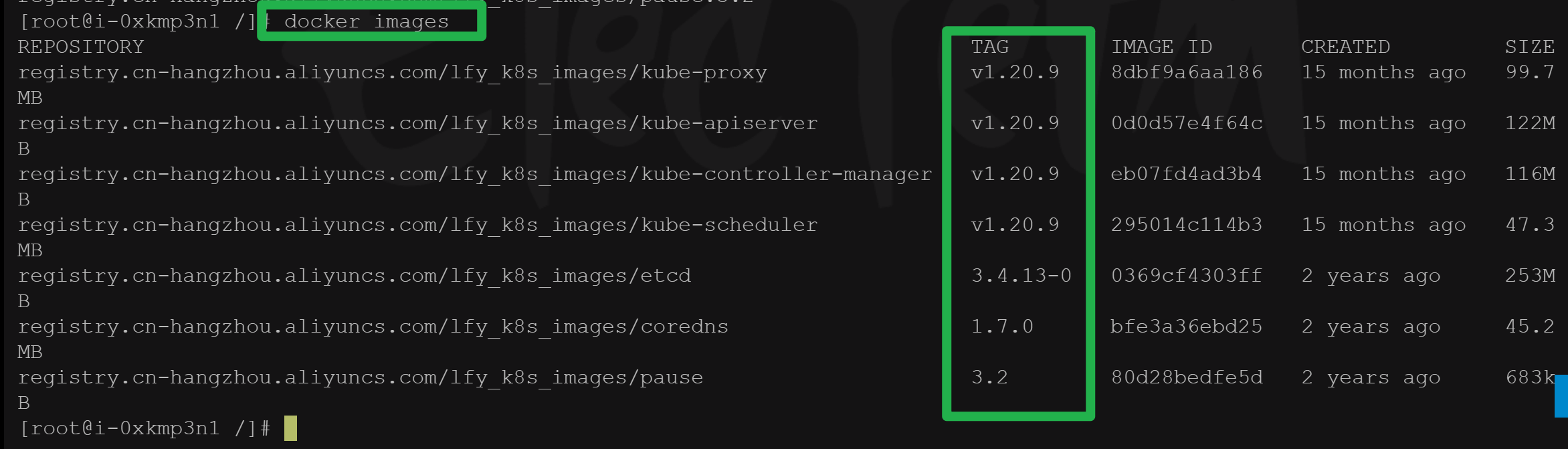

下载各个机器需要的镜像

sudo tee ./images.sh <<-'EOF'

#!/bin/bash

images=(

kube-apiserver:v1.20.9

kube-proxy:v1.20.9

kube-controller-manager:v1.20.9

kube-scheduler:v1.20.9

coredns:1.7.0

etcd:3.4.13-0

pause:3.2

)

for imageName in ${images[@]} ; do

docker pull registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images/$imageName

done

EOF

chmod +x ./images.sh && ./images.sh #授予权限并且执行脚本

大概等了一会会就可以检索了

docker images

初始化主结点

⚠️ 下面一定要按照自己的情况修改

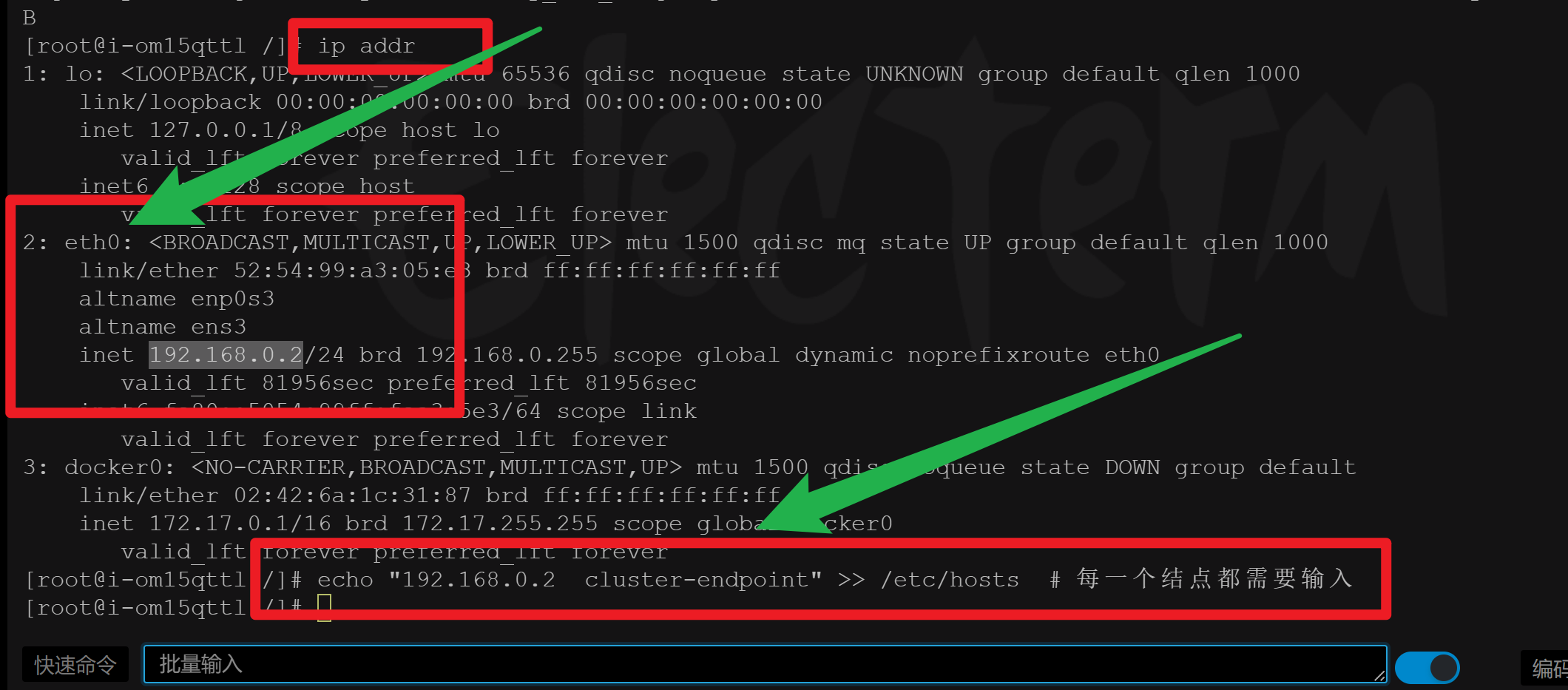

使用

ip addr(ip a)查看自己的内网地址。192.168.0.2

#所有机器添加master域名映射,以下需要修改为自己的

echo "192.168.0.2 cluster-endpoint" >> /etc/hosts # 每一个结点都需要输入

# 需要每一个结点能ping通

#主节点初始化 --apiserver-advertise-address改为master结点ip

kubeadm init \

--apiserver-advertise-address=192.168.0.2 \

--control-plane-endpoint=cluster-endpoint \

--image-repository registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images \

--kubernetes-version v1.20.9 \

--service-cidr=10.96.0.0/16 \

--pod-network-cidr=192.168.0.0/16

#所有网络范围不重叠

参考:

kubeadm init --pod-network-cidr=10.244.0.0/16 --apiserver-advertise-address=192.168.131.128

📜 对上面的解释:

一定要注意每一个结点都需要能

ping通cluster-endpoint主节点初始化:注意版本和网络范围的配置,这个挺麻烦的后面除非特别深入这一块,否则不要改。

--apiserver-advertise-address一定要改成自己的master结点的ip如果要改:

--service-cidr=10.96.0.0/16 \ --pod-network-cidr=192.168.0.0/16所有网络范围一定不能重叠!!!

--apiserver-advertise-address可以设置 control-plane 节点 API server 的 通告地址。--control-plane-endpoint可以设置所有control-plane 节点的 shared endpoint。--control-plane-endpoint允许IP地址,也允许DNS names。请联系管理员设置DNS和IP的映射。

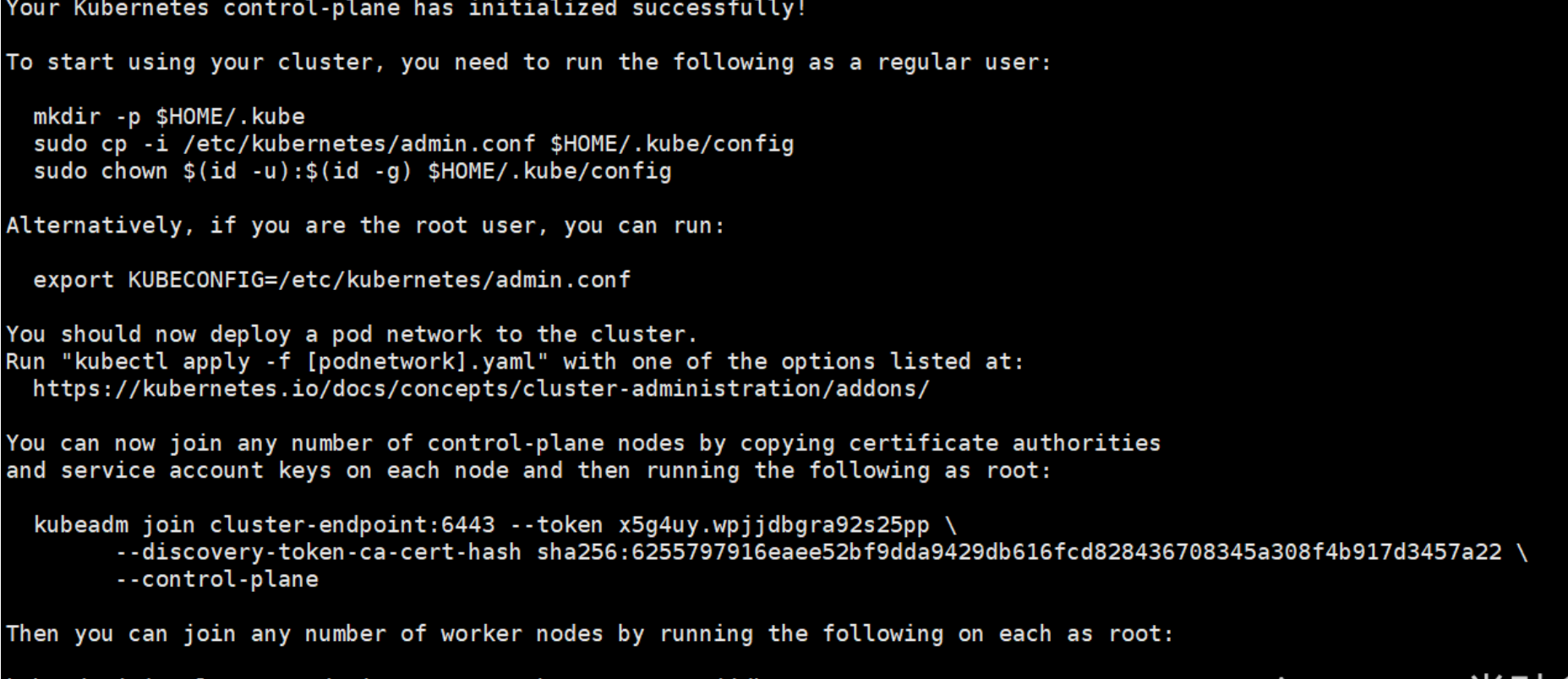

你的Kubernetes控制平面已经初始化成功!

要开始使用您的集群,您需要作为普通用户运行以下命令:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

或者,如果你是root用户,你可以运行:

export KUBECONFIG=/etc/kubernetes/admin.conf

现在应该将pod网络部署到集群。

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

您现在可以通过复制证书颁发机构来加入任意数量的控制平面节点

和每个节点上的服务帐户密钥,然后以root身份运行以下命令:

kubeadm join cluster-endpoint:6443 --token hums8f.vyx71prsg74ofce7 \

--discovery-token-ca-cert-hash sha256:a394d059dd51d68bb007a532a037d0a477131480ae95f75840c461e85e2c6ae3 \

--control-plane

然后你可以加入任意数量的工作节点,在每个工作节点上以root身份运行以下命令:

kubeadm join cluster-endpoint:6443 --token hums8f.vyx71prsg74ofce7 \

--discovery-token-ca-cert-hash sha256:a394d059dd51d68bb007a532a037d0a477131480ae95f75840c461e85e2c6ae3

注意替换 token

继续:

#查看集群所有节点

kubectl get nodes

#根据配置文件,给集群创建资源

kubectl apply -f xxxx.yaml

#查看集群部署了哪些应用?

docker ps === kubectl get pods -A

# 运行中的应用在docker里面叫容器,在k8s里面叫Pod

kubectl get pods -A

根据提示继续

master成功后提示如下:

1、设置.kube/config

2、安装网络组件

- [x] calico官网

curl https://docs.projectcalico.org/manifests/calico.yaml -O

kubectl apply -f calico.yaml

加入node节点

kubeadm join cluster-endpoint:6443 --token x5g4uy.wpjjdbgra92s25pp \

--discovery-token-ca-cert-hash sha256:6255797916eaee52bf9dda9429db616fcd828436708345a308f4b917d3457a22

新令牌

kubeadm token create --print-join-command高可用部署方式,也是在这一步的时候,使用添加主节点的命令即可

当然,这些其实都是小问题,后期的运维和维护才是 大 boss, 这也是我们穷尽一生去学习的。

END 链接

✴️版权声明 © :本书所有内容遵循CC-BY-SA 3.0协议(署名-相同方式共享)©